前言:本文主要介绍使用个人电脑或服务器本地搭建阿里开源的Qwen2.5 AI大模型,可以用于AI对话、接入微信自动回复机器人、知识库问答系统等,面向小白,过程会比较详细的介绍从系统镜像安装、环境配置、使用Ollama下载模型到模型使用。内容大纲:- 1.配置要求&模型选择

- 2.系统选择&安装

- 3.模型下载

- 4.从Hugging Face下载模型

- 5.显卡驱动安装(Linux)

- ······

一、配置要求&模型选择可以前往

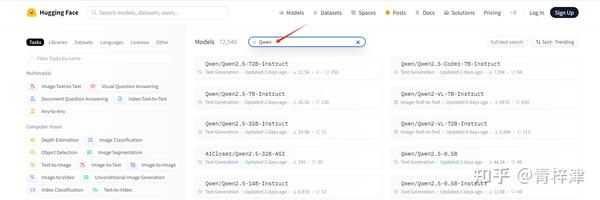

Hugging Face模型站查看现有的开源模型,阿里在上周开源了Qwen2.5模型,各方面成绩远超Qwen2.0,可以在输入框中搜索Qwen,能看到非常多的模型

图片中的模型名称后面的数字和字母通常表示模型的规模和架构。以下是解释:

- 表示模型的参数规模:

- 7B:表示模型有70亿个参数(B表示“billion”,即十亿)。

- 32B:表示模型有320亿个参数。

- 0.5B:表示模型有5亿个参数。

- 字母(例如Instruct, VL, Coder):

- Instruct:表示这是一个指令优化模型,专门用于处理人类指令,特别适合回答问题和执行复杂的对话任务。

- VL:通常表示“Vision-Language”,指这是一个多模态模型,可以同时处理视觉(图像)和语言输入。

- Coder:表示这是一个专门用于代码生成和处理的模型,适合编程相关任务。

所以,举例来说:

- Qwen2.5-72B-Instruct:表示这个模型有72亿参数,是一个指令优化模型。

- Qwen2.5-Coder-7B:表示这是一个拥有7亿参数的代码生成模型。

INT4,INT8代表该模型进行量化,降低了运行所需配置门槛

大致参考:

核显电脑,可以运行0.5B,2B参数的模型进行体验,但是效果很差

12g显存,可以运行8B参数模型

16g显存,可以运行14B参数模型

24g显存,可以运行32B参数模型

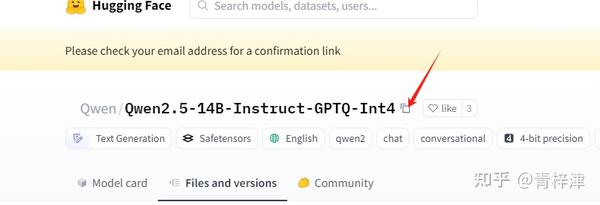

我电脑配置是i5-13k CPU,4060ti 16g显卡,打算部署Qwen/Qwen2.5-14B模型,由于我希望用于多线程处理多个文档,所以打算部署显存占用更低的量化模型,即Qwen/Qwen2.5-14B-Instruct-GPTQ-Int4。

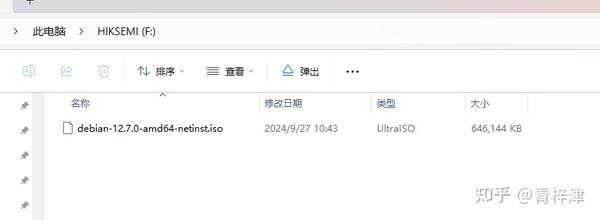

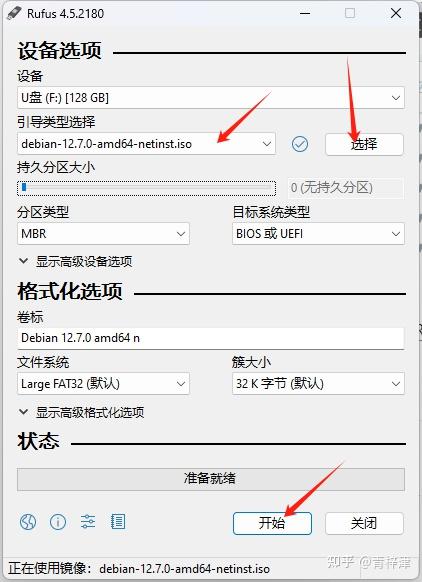

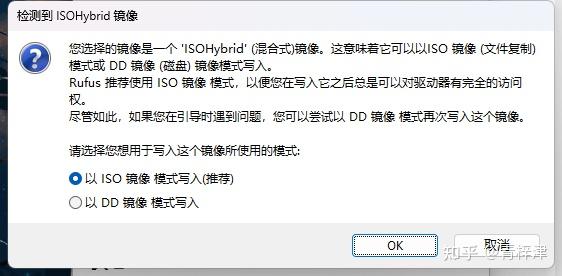

二、系统选择&安装(如果在个人电脑上安装,可以跳过这一步)我们需要下载想要安装的系统镜像文件,win10、Centos都可以,我这里选择最近比较流行的Debian系统(Linux的发行版)下载地址

Debian系统,点击下载即可(这里下载的是精简版本,需要的文件会在安装时候联网下载,离线环境安装可以直接下载

完整包)

最后会得到一个iso镜像文件

等待完成即可,把U盘插入需要安装系统的主机

然后在需要安装系统的主机,点击开机键后,连续点击F2或者Del(不同电脑不一样),进入bois模式,点击高级=》点击启动=》选择U盘名称的启动项进入,接下来就是图形化的安装界面了

安装完成后,我新建了一个用户:youce

1、通过命令将 youce 用户添加到 sudo 组

首先,切换到root账号下,执行如下命令 :

suusermod -aG sudo youcenewgrp sudo

之后,通过 su 命令切换会 youce 账号即可使用 sudo 命令。

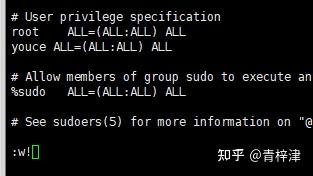

2、通过编辑/etc/sudoers文件将 linux265 加入 sudoers 文件中。

首先,通过 su - 命令切换到 root 账号下。

su

然后,输入 root 账号密码后,通过 vi 编辑 /etc/sudoers 文件。 关于 vi 基本命令操作可以查看

vi/vim教程。

按i键进入编辑模式,找到

# User privilege specificationroot ALL=(ALL:ALL) ALL

在他的下方加上一行

# User privilege specificationroot ALL=(ALL:ALL) ALLyouce ALL=(ALL:ALL) ALL

之后按esc键退出编辑模式,输入冒号,w!键进行强制保存(因为是只读文件),然后冒号,q退出

然后添加一下国内镜像源

vi /etc/apt/sources.list

按下i到编辑模式

# 中科大镜像源deb https://mirrors.ustc.edu.cn/debian/ bookworm main contrib non-free non-free-firmware# deb-src https://mirrors.ustc.edu.cn/debian/ bookworm main contrib non-free non-free-firmwaredeb https://mirrors.ustc.edu.cn/debian/ bookworm-updates main contrib non-free non-free-firmware# deb-src https://mirrors.ustc.edu.cn/debian/ bookworm-updates main contrib non-free non-free-firmwaredeb https://mirrors.ustc.edu.cn/debian/ bookworm-backports main contrib non-free non-free-firmware# deb-src https://mirrors.ustc.edu.cn/debian/ bookworm-backports main contrib non-free non-free-firmwaredeb https://mirrors.ustc.edu.cn/debian-security/ bookworm-security main contrib non-free non-free-firmware# deb-src https://mirrors.ustc.edu.cn/debian-security/ bookworm-security main contrib non-free non-free-firmware

粘贴,按esc键退出编辑模式,输入冒号,w!键进行强制保存,然后冒号,q退出

sudo apt update

到此就完成了

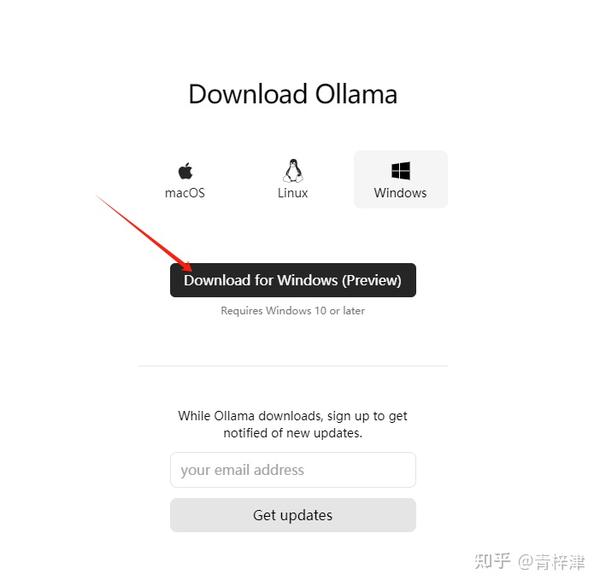

三、模型下载

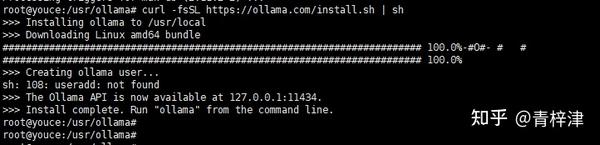

2.如果是centos或者上面安装的debian系统

我在根目录 /usr目录下,新建了ollama文件夹

cd /usr#创建目录mkdir ollama# 下载curlapt install curl

然后复制官方的指令进行下载

curl -fsSL https://ollama.com/install.sh | sh

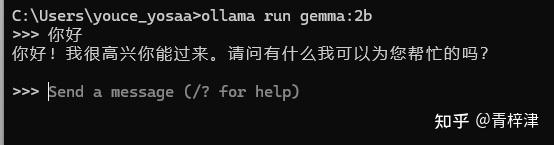

如果是安装ollama的models中有的模型,可以直接复制后在cmd或其他命令行窗口执行

例如Window,打开命令提示符

ollama run gemma:2b

等待执行结束,就可以进行对话了

四、从Hugging Face下载模型

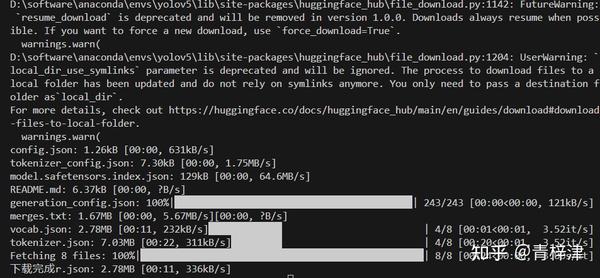

四、从Hugging Face下载模型我使用的是Python3.8环境,创建一个download.py文件,把以内内容中repo_id的模型ID改成自己想要下载的模型ID

#coding=utf-8from huggingface_hub import snapshot_downloadimport osos.environ["HF_ENDPOINT"] = "https://hf-mirror.com"#huggingface上的模型名称repo_id = "Qwen/Qwen2.5-14B-Instruct-GPTQ-Int4"#本地存储地址local_dir = "./models/Qwen2.5-14B-Instruct-GPTQ-Int4"cache_dir = local_dir + "\\cache"while True: try: snapshot_download(cache_dir=cache_dir, local_dir=local_dir, repo_id=repo_id, local_dir_use_symlinks=False, resume_download=True, allow_patterns=["*.model", "*.json", "*.bin", "*.py", "*.md", "*.txt"], ignore_patterns=["*.safetensors", "*.msgpack", "*.h5", "*.ot",], ) except Exception as e : print(e) else: print('下载完成') break

设置环境变量

Linux

export HF_ENDPOINT=https://hf-mirror.com

Windows Powershell

$env:HF_ENDPOINT = "https://hf-mirror.com"

安装依赖

pip install huggingface_hub

然后执行脚本

python download.py

等待下载完成

五、显卡驱动安装

五、显卡驱动安装电脑需要安装显卡对应驱动,不然模型会自动转为CPU推理

Windows电脑基本购买后都自带驱动

Centos、Debian等发行版的Linux需要自己安装驱动

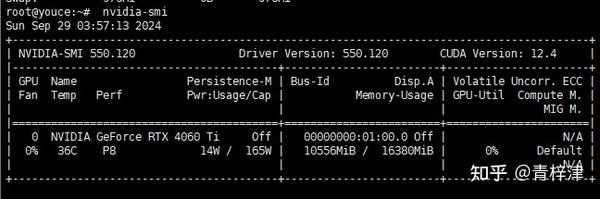

以我的Debian12为例,显卡RTX 4060ti

按照自己的型号选择选项,注意操作系统要选Linux 64-bit(不是带Aarch的版本)

点击下载会得到一个xxxx.run的文件,我们发送到需要安装驱动的电脑或服务器中

打开终端并使用root权限登录

更新系统软件包列表

apt update# 安装必要的软件包apt install build-essential linux-headers-$(uname -r)# 禁用nouveau驱动echo "blacklist nouveau" | sudo tee -a /etc/modprobe.d/blacklist.confecho "options nouveau modeset=0" | sudo tee -a /etc/modprobe.d/blacklist.confsudo update-initramfs -u# 重启系统reboot

来到下载的驱动程序目录

# 设置驱动程序为可执行chmod +x NVIDIA-Linux-x86_64-<version>.run # 替换成自己的驱动名称# 安装驱动程序sudo ./NVIDIA-Linux-x86_64-<version>.run # 替换成自己的驱动名称

按照安装过程中的提示操作

可能需要接受许可协议和重新启动系统

安装完后,输入

nvidia-smi

如果出现显卡信息,则安装成功